Amerikanske forskere har utviklet en testmetode som kan avsløre når kunstig intelligens i for eksempel selvkjørende biler, foretar potensielt fatale feilbedømninger.

Til tross for stadig flere og mer avanserte sensorer, kjører selvkjørende biler fremdeles feil en gang iblant.

Det kanskje mest kjente uhellet skjedde i 2016, da autopilot-systemet i en Tesla Model S ikke var i stand til å identifisere en hvit lastebil mot en klar himmel. Teslaen kjørte på en vei i Florida, og føreren hadde satt bilen på autopilot. Men da lastebilen krysset veien foran Teslaen, oppdaget verken føreren eller bilen faren. Teslaen raste inn i lastebilen uten å senke farten i det hele tatt, og den 40-årige føreren ble drept i kollisjonen.

Utfordringen for dem som jobber med kunstig intelligens, er at det er svært vanskelig å gjennomskue hva som får systemene til å trekke feilslutninger.

Forskerne har konsentrert seg om den typen kunstig intelligens som bygger på nevrale nettverk. Disse systemene er bygd opp som lag av nevroner. Hvert lag bruker input fra det foregående laget som grunnlag for sin egen mønsteranalyse.

Metoden er svært effektiv for en lang rekke problemer – for eksempel bildegjenkjennelse – men det er svært vanskelig å finne hvor i systemene eventuelle feilslutninger oppstår. Derfor blir kunstige intelligenssystemer ofte omtalt som «svarte bokser».

- Ti ganger kraftigere enn den Tesla bruker i dag: Hevder de har utviklet datamaskinen som skal gjøre selvkjørende biler til virkelighet

Åpner den «svarte boksen»

Men nå har forskere fra Columbia University og Lehigh University utviklet en metode som kan åpne de svarte boksene litt ved å gjenskape og analysere den metoden som brukes for å lære opp kunstig intelligens, slik at man kan forstå logikken i systemet.

Dette forteller en av forskerne, Suman Jana fra Columbia Engineering, til nyhetstjenesten Eurekalert.

«Det gir deg en viss innsikt i hva systemet gjør, og hvor det oppstår feil.»

Resultatene har blitt publisert i en artikkel, og forskerne presenterer også ideene sine på en konferanse i Shanghai.

Eksisterende tester tar tid og dekker ikke nok

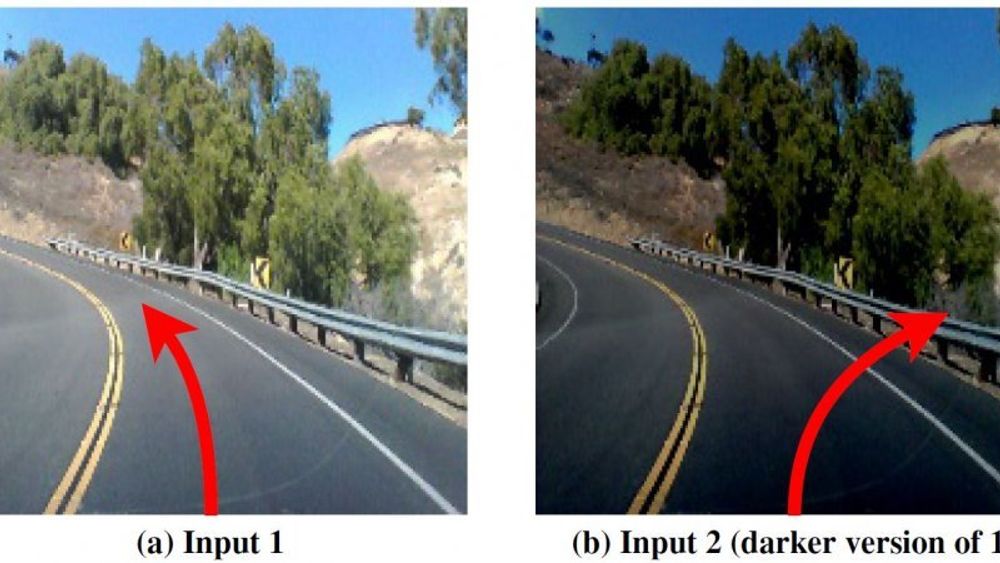

I dag tester man kunstig intelligens på to måter: Man tar for eksempel et foto og endrer litt på det. Man kan blant annet gjøre det litt mørkere. Et menneske vil avlese de to fotoene på samme måte, men en kunstig intelligens vil i noen tilfeller avlese bildene helt forskjellig, og foreta radikalt forskjellige handlinger.

Utfordringen ved denne metoden er at det er umulig å samle bilder av alle de ulike problemstillingene som en selvkjørende bil kan bli utsatt for.

En annen metode er å bruke manipulerte bilder og få en datamaskin til å kontinuerlig endre litt på bildene og sende dem gjennom den kunstige intelligens igjen og igjen, inntil systemet endrer tolkningen sin.

Men for begge testmetodene gjelder det at man ikke kan være sikker på å ha testet alle nevroner i den kunstige intelligensen. Og begge metoder krever dessuten en stor manuell innsats.

- (Les hos danske Ingeniøren) Etikk-professor: Hvis vi gir en robot skylden - hvordan skal vi straffe den?

Finner de beste feilene

De amerikanske forskernes innfallsvinkel er å måle hvor mange av nevronene som blir aktivert av de forskjellige input-parameterne. Dessuten tester de samme input-parametere i flere forskjellige kunstige intelligenser – for eksempel i både Googles, Teslas og GMs programvare.

Hvis ett av de tre systemene foretar et annet valg basert på samme input, er dette noe som tyder på at der er feil i det aktuelle systemet. Denne typen test har ifølge forskernes artikkel vært brukt til å teste vanlig logikkbasert programvare. Men metoden kan også brukes på kunstig intelligens.

Forskernes verktøy, som kalles DeepXplore, kan selv finne fram til den typen data som aktiverer så mange nevroner som mulig samtidig, og utløser så mange feilslutninger som mulig.

Resultatene kan deretter brukes til å trene systemene til å oppdage sine egne avvik, slik at valgene deres blir mer korrekte.

Forskerne har lagt ut koden til DeepXplore på Github, slik at andre interesserte kan teste egne systemer og datasett.

Artikkelen ble først publisert på Ing.dk.

- Teknologien skal gjøre biler selvkjørende i 2021: Her er historien bak oppkjøpet på 130 milliarder